Nvidia Blackwell ускоряет ИИ в 2,5 раза: новый рекорд производительности в обучении гигантских языковых моделей

Nvidia объявила о впечатляющих результатах своих новых чипов Blackwell в тестах MLPerf Training v5.0. Архитектура Blackwell, разработанная для удовлетворения растущих требований к производительности современных AI-приложений, продемонстрировала наивысшую производительность во всех бенчмарках, став единственной платформой, представившей результаты по всем тестам. Это особенно впечатляет на самом сложном тесте, ориентированном на большие языковые модели (LLM) — обучении модели Llama 3.1 405B.

Результаты, полученные с использованием двух суперкомпьютеров на базе Blackwell — Tyche и Nyx, а также в сотрудничестве с CoreWeave и IBM (2496 GPU Blackwell и 1248 CPU Nvidia Grace), были тщательно проверены и подтверждены ассоциацией MLCommons, объединяющей более 125 членов и партнёров.

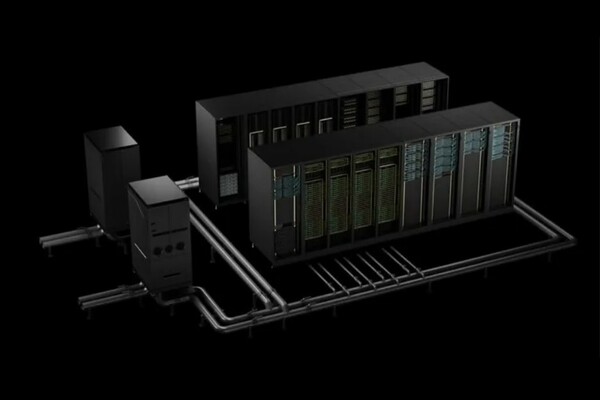

В сравнении с предыдущим поколением архитектуры, Blackwell показал прирост производительности в 2,2 раза на тесте Llama 3.1 405B. На тесте Llama 2 70B LoRA fine-tuning системы Nvidia DGX B200, оснащённые восемью GPU Blackwell, продемонстрировали 2,5-кратное увеличение производительности по сравнению с результатами предыдущего раунда тестирования при использовании того же количества графических процессоров. Такой значительный скачок производительности обусловлен рядом инноваций: жидкостным охлаждением стоек, 13,4 ТБ когерентной памяти на стойку, использованием технологии межсоединения Nvidia NVLink пятого поколения и Nvidia NVLink Switch для масштабирования и сетевой технологии Nvidia Quantum-2 InfiniBand для горизонтального масштабирования. Кроме того, усовершенствования в программном стеке Nvidia NeMo Framework повышают эффективность обучения многомодальных LLM следующего поколения, что важно для вывода на рынок агентивных AI-приложений.

Эти приложения-агенты, способные к рассуждению и решению задач, будут работать в так называемых «AI-фабриках» — центрах обработки данных, оптимизированных для работы с подобными системами. Они будут генерировать ценную информацию, применимую во многих отраслях и академических областях. Платформа Nvidia для центров обработки данных включает в себя GPU, CPU, высокоскоростные сети и обширный набор программного обеспечения, включая библиотеки Nvidia CUDA-X, фреймворк NeMo, Nvidia TensorRT-LLM и Nvidia Dynamo. Такое комплексное решение позволяет организациям ускорить обучение и внедрение моделей, значительно сокращая время выхода на рынок.

Дэйв Сальватор, директор по продуктам ускоренных вычислений в Nvidia, отметил, что компания сосредоточилась на результатах предварительного и последующего обучения, подчеркнув, что это начальный этап инвестиций в ИИ, а получение прибыли начинается на этапе вывода моделей в эксплуатацию. Он также указал на то, что MLPerf является надёжным бенчмарком, гарантирующим объективное сравнение производительности различных систем.

Nvidia планирует дальнейшее повышение производительности Blackwell с помощью программных оптимизаций и адаптации к новым, более сложным задачам. Переход Nvidia от производителя чипов к созданию целых систем, стоек и центров обработки данных, названных «AI-фабриками», позволяет компании предлагать комплексные решения для ускорения развития искусственного интеллекта.

Источник: https://www.ixbt.com/news/2025/06/05/nvidia-blackwell-2-5.html

Изображение: Nvidia

06-06-2025 16:05 75

Industry Hunter

только что

Industry Hunter

только что